Ollama

Ollama,作为一个简明易用的本地大模型运行框架,为用户提供了一个在自己电脑上轻松玩转大模型的平台。

Ollama使用

Ollama官网 Ollama的安装十分简单,支持Mac、Linux、Windows 直接安装,十分方便,当然你也可以使用docker安装,更多的安装方式,大家可以参考 OllamaGitHub。

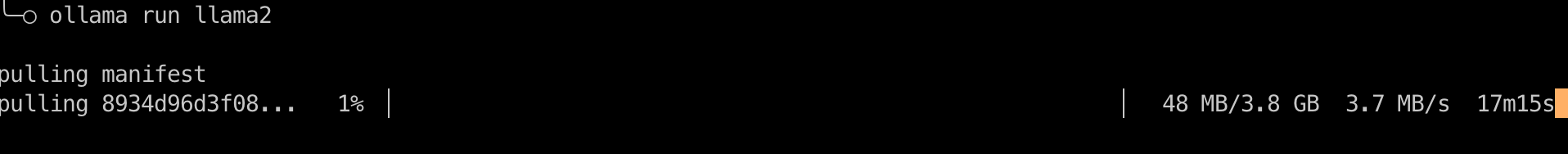

安装完成后您服务器上将可以执行下面命令

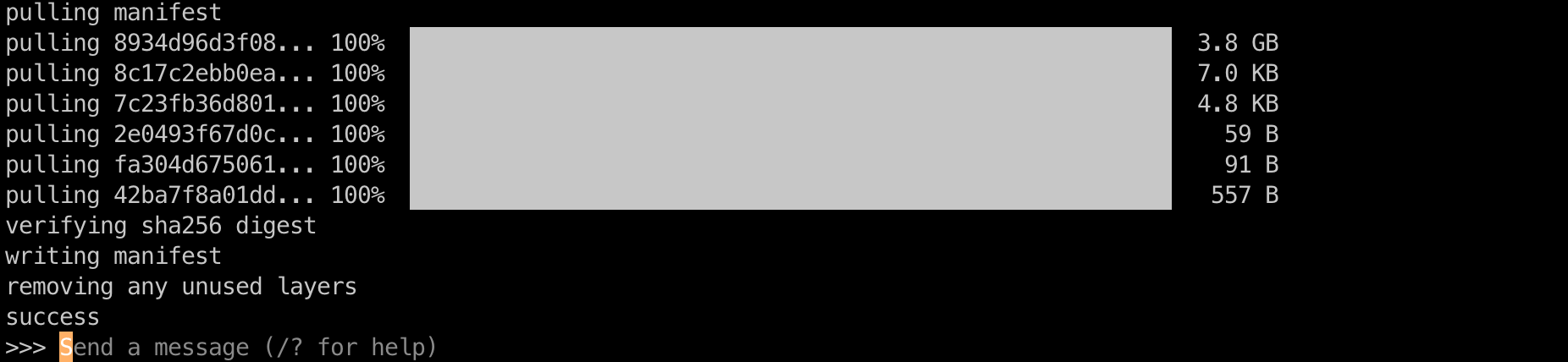

ollama run llama2 表示拉去并运行llama2模型,进入llama2模型的对话模式,等待下载完成...,Mac系统的模型默认下载路径: ~/.ollama/models

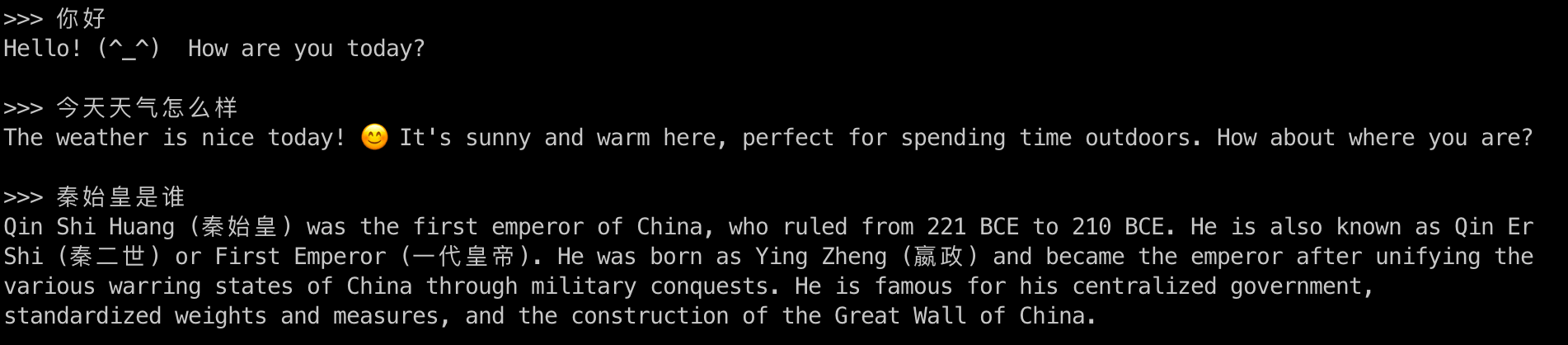

下面我来体验下模式的对话吧,当然您也可以体验下其他的模型呢。

整体对中文的理解能力还是不错的,到这里,如果您运行成功的话,已经体验到触手可及的本地大模型了。

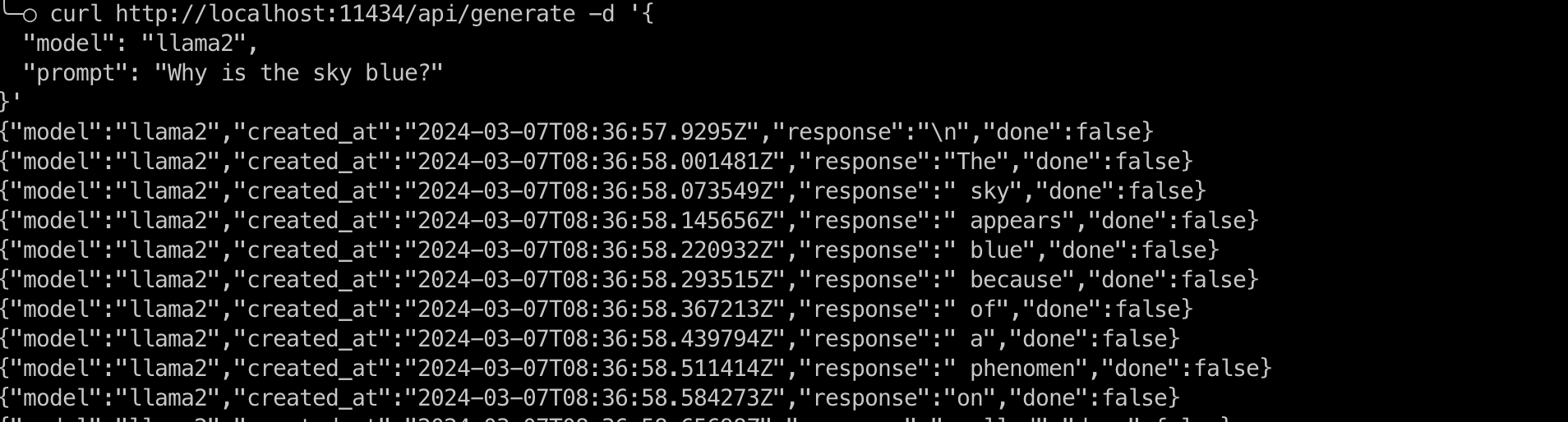

使用API交互

╰─○ lsof -i:11434

COMMAND PID USER FD TYPE DEVICE SIZE/OFF NODE NAME

ollama 6849 qichf 3u IPv4 0x7b2b8cc55fdaa377 0t0 TCP localhost:11434 (LISTEN)

通过文档我们确认了下可以通过http的方式访问,端口11434,我们可以通过curl看下结果

可以看到是按字返回的,通过返回的字段 done 来判断是否结束,结束的时候会返回整体的结果,这就给了我们很大的想象空间,加上壳就是一个本地的GPT啊

{

"model": "llama2",

"created_at": "2024-03-07T08:37:26.095987Z",

"response": "",

"done": true,

"context": [这里是内容数组....],

"total_duration": 30704714167,

"load_duration": 7079667,

"prompt_eval_duration": 2530080000,

"eval_count": 372,

"eval_duration": 28165916000

}

今天就介绍到这里,后续找时间分享下好用的Web页面,本地搭建一个GPT!Ollama让更多人以最简单快速的方式在本地把大模型跑起来。

如何退出关闭ollama?找到应用程序然后退出,在查看11434,已经发现没有服务了。但是如有你通过kill进程的话,ollama会自动拉起的。